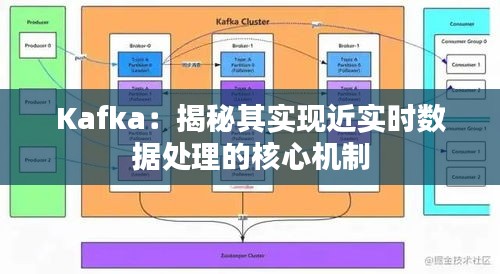

标题:Kafka:揭秘其实现近实时数据处理的核心机制

引言

Kafka作为一种分布式流处理平台,因其高吞吐量、可扩展性和容错性而备受青睐。在当今大数据时代,实时数据处理能力成为衡量数据处理系统性能的重要指标。Kafka以其卓越的近实时数据处理能力在众多系统中脱颖而出。本文将深入探讨Kafka实现近实时数据处理的核心机制。

分布式架构

Kafka采用分布式架构,将数据存储在多个服务器上,从而实现高可用性和可扩展性。在分布式系统中,数据分区(Partition)是核心概念之一。Kafka将消息队列划分为多个分区,每个分区存储在集群中的不同服务器上。这种设计使得Kafka能够实现水平扩展,提高系统吞吐量。

消息队列

Kafka通过消息队列实现数据的存储和传输。消息队列是一种先进先出(FIFO)的数据结构,能够保证消息的顺序性。Kafka的消息队列具有以下特点:

1. 高吞吐量:Kafka能够处理高并发消息,实现每秒数百万条消息的吞吐量。

2. 可扩展性:通过增加服务器节点,Kafka能够线性扩展其处理能力。

3. 容错性:Kafka采用副本机制,确保数据在发生故障时不会丢失。

零拷贝技术

Kafka在数据传输过程中采用了零拷贝技术,有效提高了数据传输效率。零拷贝技术通过减少数据在内核空间和用户空间之间的拷贝次数,降低CPU和内存的消耗。具体实现如下:

1. 使用sendfile系统调用:sendfile系统调用能够直接在内核空间完成数据的传输,避免在用户空间进行不必要的拷贝。

2. 利用内存映射:Kafka将数据存储在内存映射文件中,通过映射文件实现数据的快速读写。

日志索引

Kafka采用日志索引机制,实现快速的消息检索。日志索引是一种数据结构,用于存储消息的偏移量(Offset)和位置信息。通过日志索引,Kafka能够快速定位到指定消息,提高数据处理效率。

消费者组

Kafka引入了消费者组(Consumer Group)的概念,允许多个消费者实例共同消费同一个主题(Topic)的消息。消费者组内部实现负载均衡,确保每个消费者实例都能均衡地消费消息。这种设计使得Kafka能够实现高并发数据处理。

总结

Kafka通过分布式架构、消息队列、零拷贝技术、日志索引和消费者组等核心机制,实现了近实时数据处理。这些机制相互配合,使得Kafka在处理大规模、高并发数据时表现出色。随着大数据时代的到来,Kafka作为一款优秀的实时数据处理平台,将在各个领域发挥越来越重要的作用。

转载请注明来自武汉厨博士餐饮管理有限公司,本文标题:《Kafka:揭秘其实现近实时数据处理的核心机制》

鄂ICP备14007991号-17

鄂ICP备14007991号-17